Скачать сайт из интернета иногда бывает очень даже полезно. Например, у Вас не всегда есть доступ в интернет, и Вы можете просматривать интересующую Вас информацию в офлайн. Или Вы находитесь в том месте, где нет интернет покрытия, например в глубоком лесу. Конечно, отсутствие интернета в наш век это практически редкость, но такие случаи есть. Да и скачанные странички сайта загружаются мгновенно и не нужно ничего ждать, если у Вас низкая скорость интернета.

Скачать можно любые ресурсы точно так же, как мы скачиваем какие-то другие файлы, типа музыки и фильмов. А вот огромные ресурсы, такие, как социальные сети скачать вряд ли получится, так как они просто не поместятся на Вашем компьютере. Для этого уже понадобятся огромные сервера с большим количеством памяти.

После того, как Вы скачали нужный сайт. Его можно просматривать в офлайн, когда у Вас нет интернета. Позже, если на сайте произойдут какие-то обновления, их потом также можно будет скачать.

Как скачать сайт?

Скачать сайт из интернета очень легко. Вообще, для этого существуют специальные программы – браузеры. Но они в основном платные. Есть более простой и бесплатный вариант – программа WinHTTrack WebSite Copier. C помощью этой полезной штуки мы будем скачивать сайты совершенно бесплатно.

Скачать программу Вы сможете с официального сайта. Там много версий для разных разрядностей и операционных систем и весит она не много. Приступим уже к установке.

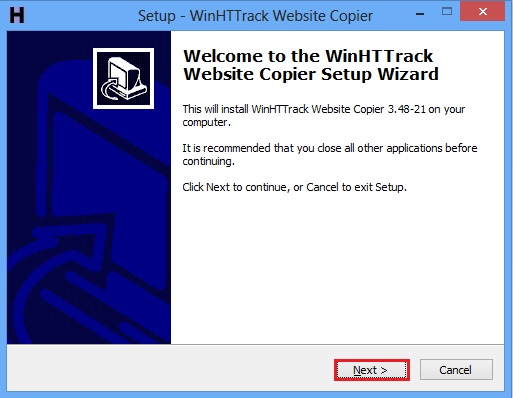

Запускаем скачанный файл программы и видим окно инсталлятора, где нажимаем Next:

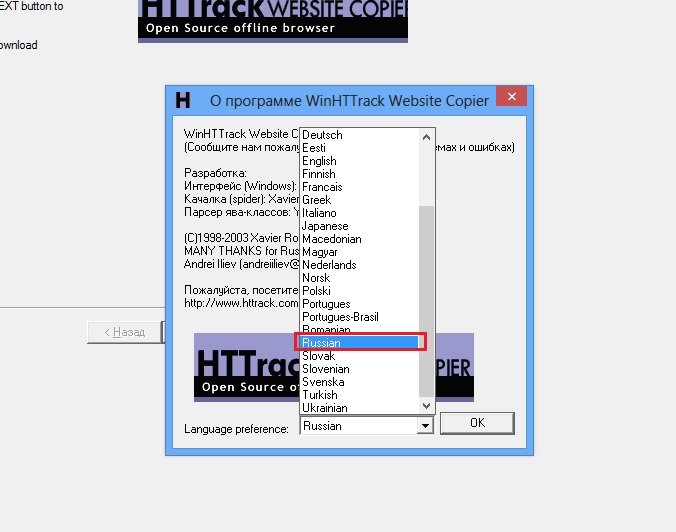

Дальше установка по стандарту, я думаю, Вы разберетесь. После установки, запускаем программу. В открывшемся окне, нам предлагают выбрать язык программы. Выбираем русский и перезагружаем ее.

Теперь заново запускаем программу и нажимаем далее.

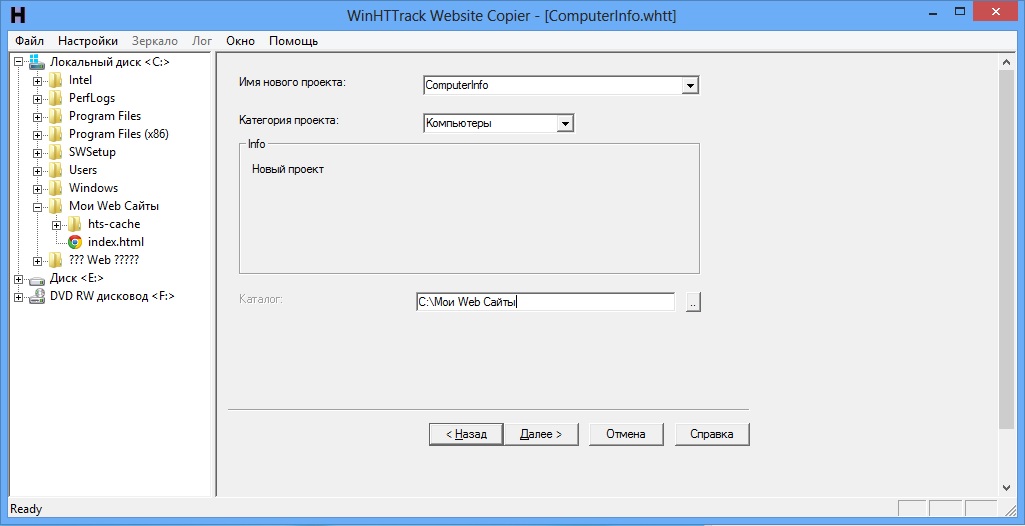

Здесь мы должны указать имя проекта и категорию, выбираем на свой вкус, но желательно выбирать под тематику сайта, который Вы собираетесь скачивать. Еще ниже выбираем путь, куда будем сохранять сайт. Лучше выбирать не системный диск.

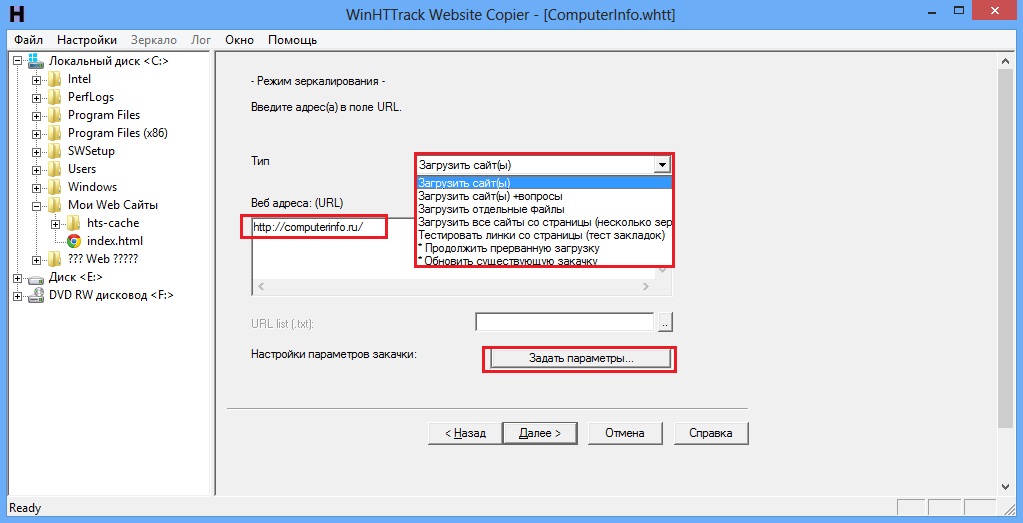

Нажимаем далее. В окне Веб адреса: (URL) вводим адрес сайта, который хотим скачать. В поле тип мы можем выбрать несколько функций. Обратите внимание, когда Вы будете обновлять скачанный сайт, то выбирайте «Обновить существующую закачку». Если у Вас по какой-то причине закачка прервалась в первый раз, то выбираем «Продолжить прерванную закачку» и начинаем процесс. Еще можно задать некоторые параметры закачки, чтобы это сделать, нажимаем «Задать параметры…».

Дополнительные параметры скачивания

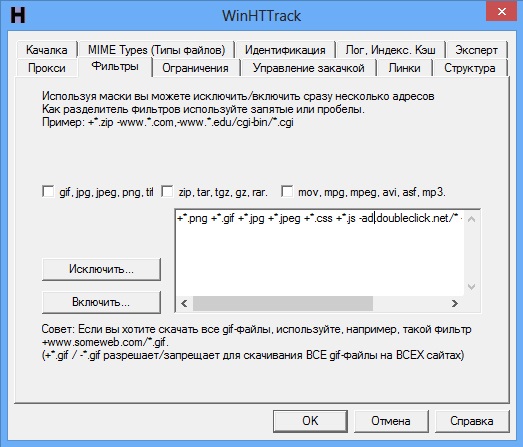

В принципе, эти параметры можно и не трогать, но мы их рассмотрим. Для начала перейдите во вкладку «Фильтры», как видите, здесь мы можем исключить те форматы файлов, которые нам не нужно загружать, или наоборот, можно выделить какие-то дополнительные.

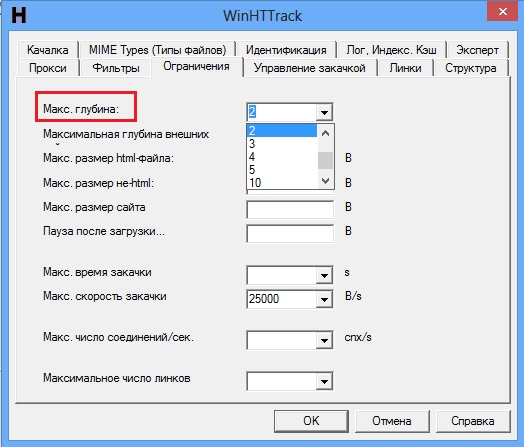

Следующая вкладка: «Ограничения». Здесь мы можем указать глубину сканирования сайта, то есть, если вы поставите глубину 2, то скачаются только главная страница сайта и страницы, ссылки которых расположены на главной. Лучше выбирать побольше. Ну, в остальном можно ничего не трогать.

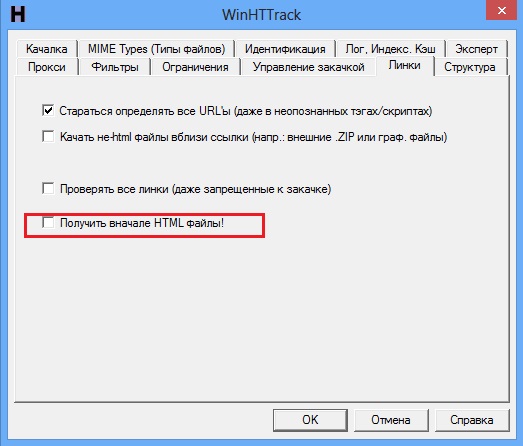

Во вкладке «Линки» можно установить галочку «Получить вначале HTML файлы», это нужно для того, чтобы сначала скачать текстовые файлы, а только потом изображения, видео и прочие весомые файлы. Выбираете на свое усмотрение.

Итак, все параметры настроены, теперь перейдем к скачиванию сайта.

Скачивание сайта

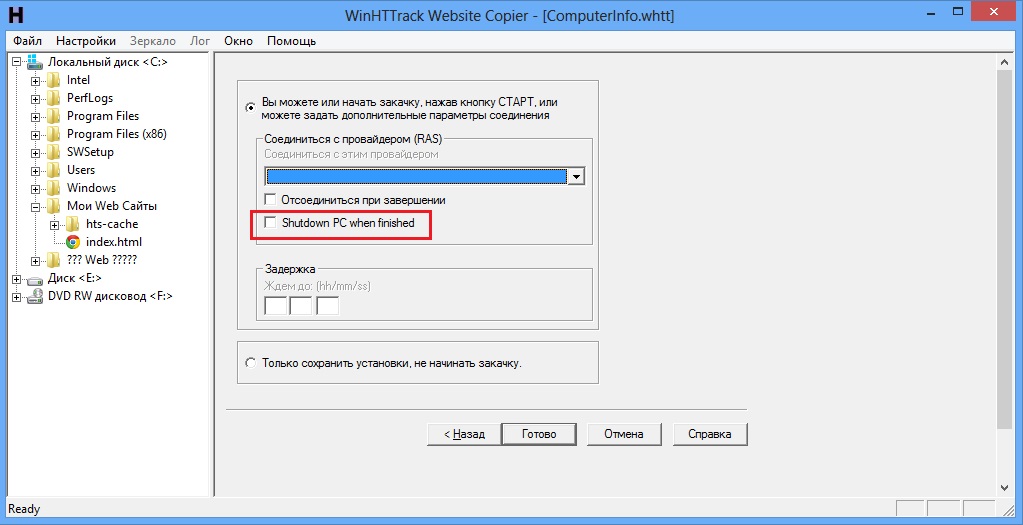

Применяем измененные параметры и в пошаговой настройке сайта, нажимаем далее. Это последний этап, на котором нам нужно нажать просто Готово. Также Вы можете отметить пункт «Shutdown PC when finished», если хотите, чтобы после скачивания сайта компьютер выключился.

В процессе работы Вы можете видеть, как скачивается сайт. На некоторых страницах можно нажать кнопку «Пропустить», чтобы не скачивать ненужные страницы.

Важно заметить одну вещь, даже некоторые молодые сайты могут скачиваться несколько часов, а проекты, которым несколько лет вообще могут качаться сутки, так что, если Вы готовы ждать, то дерзайте.

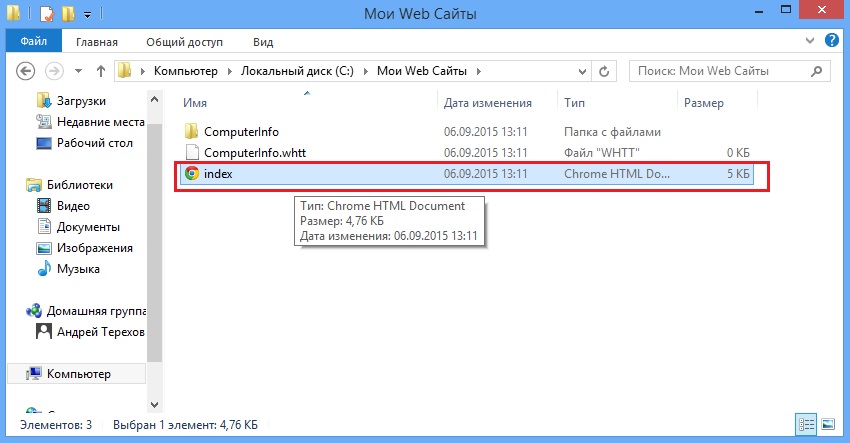

Собственно все. Как только сайт скачается, переходите в папку, где он находится и открываете файл index.html.

Откроется окно браузера, где Вы можете переходить по ссылкам и все должно работать. Если в параметрах Вы указали уровень глубины, например, 2, то ссылки с более глубоким уровнем работать не будут, это имейте ввиду.

Зачем человеку нужен сайт, если он находиться в лесу. Чушь полная. Если человек пошеп в лес, то там у него другие интересы и ему нафиг не нужен ни сайт, ни комп.